Типы моделей нейронов

4.2. Сигмоидальный нейрон

Уже рассмотренный нейрон с сигмоидальной активационной функцией классифицируется как нейрон сигмоидального типа. Так называются искусственные нейроны с S-образной активационной функцией. Вид функции мало говорит о скрывающейся за ним математике.

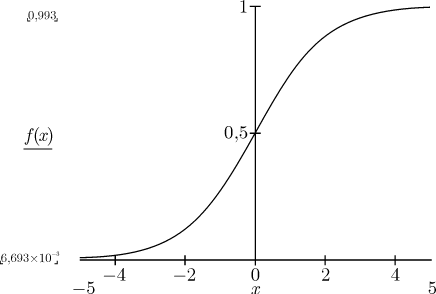

Функция активации является непрерывной и может быть выражена в виде сигмоидальной униполярной или биполярной функции. Униполярная функция, как правило, представляется формулой 3.5. Модифицируем её, введя параметр скорости β.

, 4.5 12+

, 4.5 12+

Рис. 4.2. Униполярная функция

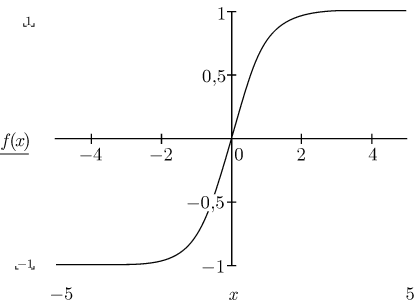

Биполярная функция задается в виде :

F(x)=tanh(βx) 4.6

Рис. 4.3. Биполярная функция

Параметр β влияет на крутизну графика функции f(x). При β→∞, сигмоидальная функция превращается в функцию ступенчатого типа, идентичную функции активации персептрона. На практике чаще всего используется значение β=1.

\ Униполярная и биполярная функции используются как активационные функции перцептрона. Важным свойством сигмоидальной функции является ее дифференцируемость. Для униполярной функции имеем

df(x)/dx=β f(x(1-f(x)) 4.7

тогда как для биполярной функции

4.8 14+

4.8 14+

β→∞

Дифференцируемость активационных функций позволяет использовать классические методы математического анализа, что придаёт рассмотрению силу доказательства. Непрерывнык функции активации позволяет использовать при обучении градиентные методы оптимизации. Проще всего реализовать метод наискорейшего спуска, в соответствии с которым уточнение вектора весов W=[w0, w2, …, wN] проводится в направлении отрицательного градиента целевой функции

E=(y-d)2/2 4.9

,где:

4.10

4.10

Компонента градиента имеет вид:

4.11

4.11

,где e=y-d означает разницу между фактическим и ожидаемым значением выходного сигнала нейрона. Если ввести обозначение δ=e·df(u)/du, то можно получить выражение, определяющее i-ю составляющую градиента в виде

4.12

4.12

Значения весовых коэффициентов уточняются по формуле

wi(t+1)=wi(t)-αδxi 4.13

,где α ϵ (0, 1)

Применение градиентного метода для обучения нейрона гарантирует достижение только локального минимума. Для выхода из окрестности локального минимума результативным может оказаться обучение с моментом. В этом методе процесс уточнения весов определяется не только информацией о градиенте функции, но и предыдущим изменением весов. Подобный способ может быть задан выражением

4.14

4.14

,в котором первый член соответствует обычному методу наискорейшего спуска, тогда как второй член, называемый моментом, отражает последнее изменение весов и не зависит от фактического значения градиента. Значение β выбирается из интервала (0,1).

<ДАЛЕЕ> <ТИПЫ МОДЕЛЕЙ>