Обучение ИНС.

6.2. Обучение с учителем.

Обучение с учи́телем (англ. Supervised learning) — один и з способов машинного обучения, в ходе которого испытуемая система принудительно обучается с помощью примеров «стимул-реакция». С точки зрения кибернетики, является одним из видов кибернетического эксперимента. Между входами и эталонными выходами (стимул-реакция) может существовать некоторая зависимость, но она неизвестна. Известна только конечная совокупность прецедентов — пар «стимул-реакция», называемая обучающей выборкой. На основе этих данных требуется восстановить зависимость (построить модель отношений стимул-реакция, пригодных для прогнозирования), то есть построить алгоритм, способный для любого объекта выдать достаточно точный ответ. Для измерения точности ответов, так же как и в обучении на примерах, может вводиться функционал качества.

Википедия

Обучение с учителем – самый очевидный способ обучения нейронных сетей. Подразумевается участие некого «Демиурга», знающего правильные ответы на все вопросы, встающие перед сетью. Вопросы формулируются в виде определенной комбинации входных сигналов, ответы – выходных сигналов сети. Если выходы сети совпадают с требуемыми, обучение не производится.

Если активен выход, который должен быть пассивен, весовые коэффициенты на путях, ведущих от активных входов рассматриваемого нейрона, уменьшаются. Если пассивен выход, который долже н быть активен, весовые коэффициенты на путях, ведущих от активных входов рассматриваемого нейрона, размер увеличиваются.

Если направление изменения весовых коэффициентов нейронов достаточно очевидно, то величина шага – вопрос спорный. Слишком большой размер шаг грозит «перелётом» и проблемами со сходимостью, малый – низкой скоростью приближения к оптимуму.

Обучение с учителем предполагает, что для каждого входного вектора существует целевой вектор, представляющий собой требуемый выход. Вместе они называются обучающей парой. Обычно сеть обучается на некотором числе таких обучающих пар. Предъявляется выходной вектор, вычисляется выход сети и сравнивается с соответствующим целевым вектором, разность (ошибка) с помощью обратной связи подается в сеть и веса изменяются в соответствии с алгоритмом, стремящимся минимизировать ошибку. Векторы обучающего множества предъявляются последовательно, вычисляются ошибки и веса подстраиваются для каждого вектора до тех пор, пока ошибка по всему обучающему массиву не достигнет приемлемо низкого уровня.

Для каждого нейрона i (всех весте или каждого в отдельности) задаётся:

Начальная погрешность выхода εi.

Или скорость обучения vi

Коэффициент шага αi ϵ ]0, 1[. При α=1 обучение происходит за один шаг. При α=0 обучение вообще не производится.

В данном случае мы выступаем в качестве эксперта, который формирует так называемое «обучающее множество», т.е. набор примеров и правильных ответов с экспертной точки зрения. Далее мы передаем, или как говорят, «скармливаем» полученное множество с набором примеров, которые обозначим как X и решений, кизменениоторые обозначим как Y в некий алгоритм, задачей которого найти некоторую функцию f (X), преобразующую множество X в множество Y

X → f (X) → Y

Такие пары множеств примеров и решений еще называют парами объект — ответ, или прецедентами. Процесс обучения с учителем также часто называют процессом обучения по прецедентам.

Технология обучения с учителем НС предполагает наличие двух однотипных множеств:

- множество учебных примеров

- используется для ''настройки'' НС - множество контрольных примеров

- используется для оценки качества работы НС

На первом этапе производится, собственно, обучение нейронной сети, то есть фактической ошибки. Фактически, исключения ситуаций, когда значение выхода нейрона не совпадает с желаемым.

На втором этапе, проводится проверка качества обучения. И, если оно не удовлетворяет требованиям разработчика, обучение повторяют.

Элементами этих двух множеств есть пары (X, YI), где

X - входной вектор для обучаемой НС;

YI – верный (желаемый) выходной вектор для X;

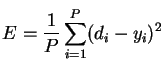

Так же определим функцию ошибки E. Обычно это средняя квадратичная ошибка (mean squared error - MSE) .

6.5

6.5

где

P - количество обработанных НС примеров;

yi - реальный выход НС;

di - желаемый (идеальный) выход НС;

Процедура обучения НС сводится к процедуре коррекции весов связей HC. Целью процедуры коррекции весов есть минимизация функции ошибки E.

Общая схема обучения с учителем выглядит так :

1. Перед началом обучения весовые коэффициенты НС устанавливаются некоторым образом, например - случайно.

2. На первом этапе на вход НС в определенном порядке подаются учебные примеры. На каждой итерации вычисляется ошибка для учебного примера EL (ошибка обучения) и по определенному алгоритму производится коррекция весов НС. Целью процедуры коррекции весов есть минимизация ошибки EL.

3. На втором этапе обучения производится проверка правильности работы НС. На вход НС в определенном порядке подаются контрольные примеры. На каждой итерации вычисляется ошибка для контрольного примера EG (ошибка обобщения). Если результат неудовлетворительный то, производится модификация множества учебных примеров1и повторение цикла обучения НС.

4. Если после нескольких итераций алгоритма обучения ошибка обучения ELуменьшается почти до нуля, в то время как ошибка обобщения EG в начале уменьшается, а затем начинает расти, то это признак эффекта переобучения. В этом случае обучение необходимо прекратить.

В случае однослойной сети алгоритм обучения с учителем - прост. Желаемые выходные значения нейронов единственного слоя заведомо известны, и подстройка весов синаптических связей идет в направлении, минимизирующем ошибку на выходе сети.

По этому принципу строится алгоритм обучения однослойного персептрона.

<ДАЛЕЕ>